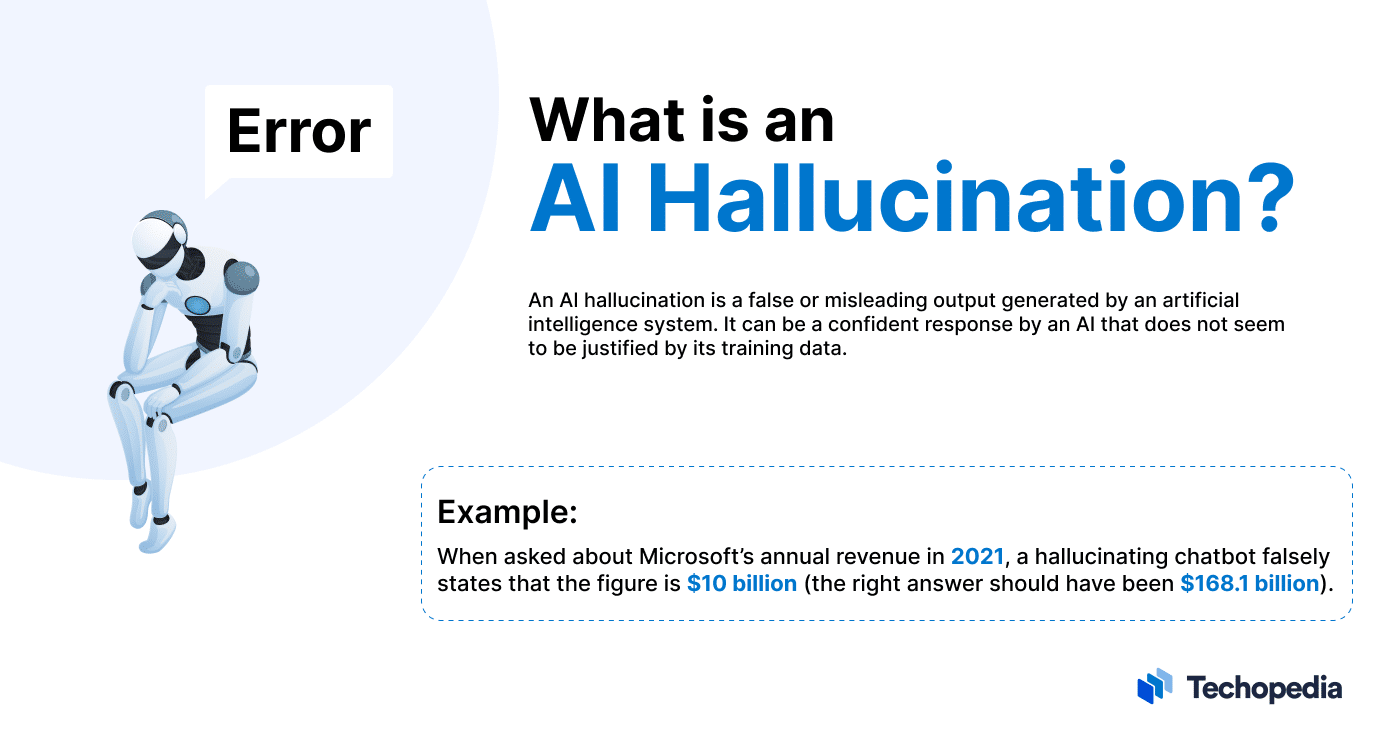

Τι είναι AI Hallucination?

Μια ψευδαίσθηση στην τεχνητή νοημοσύνη (AI Hallucination) είναι όταν ένα μεγάλο γλωσσικό μοντέλο (large language model – LLM) όπως το GPT4 της OpenAI ή το Google PaLM δημιουργεί ψευδείς πληροφορίες ή γεγονότα που δεν βασίζονται σε πραγματικά δεδομένα ή γεγονότα.

Η Avivah Litan, VP Αναλύτρια της Gartner, εξηγεί:

Οι ψευδαισθήσεις (AI Hallucination) είναι εντελώς κατασκευασμένα αποτελέσματα που προέρχονται από μεγάλα γλωσσικά μοντέλα. Παρόλο που αντιπροσωπεύουν εντελώς κατασκευασμένα γεγονότα, το LLM αποτέλεσμα τους παρουσιάζεται με αυτοπεποίθηση και αυθεντικότητα.

Τα chatbots που βασίζονται στην γενετική τεχνητή νοημοσύνη μπορούν να κατασκευάσουν οποιαδήποτε πληροφορία. Όπως για παράδειγμα ονόματα, ημερομηνίες και ιστορικά γεγονότα ή ακόμα και κώδικα.

Οι ψευδαισθήσεις είναι αρκετά συχνές και μάλιστα το OpenAI εκδίδει μια προειδοποίηση προς τους χρήστες του ChatGPT. Η προειδοποίηση δηλώνει ότι «το ChatGPT μπορεί να παράγει ανακριβείς πληροφορίες σχετικά με ανθρώπους, μέρη ή γεγονότα».

Η πρόκληση για τους χρήστες είναι να διαχωρίσουν ποιες πληροφορίες είναι αληθείς και ποιες όχι.

Παραδείγματα Ψευδαισθήσεων της Τεχνητής Νοημοσύνης

Υπάρχουν πολλαπλά παραδείγματα ψευδαισθήσεων της Τεχνητής Νοημοσύνης (AI Hallucination). Μία από τις πιο αξιοσημείωτες περιπτώσεις συνέβη ως μέρος ενός προωθητικού βίντεο που κυκλοφόρησε από την Google τον Φεβρουάριο του 2023. Τότε, το AI chatbot Bard ισχυρίστηκε λανθασμένα ότι το διαστημικό τηλεσκόπιο James Webb έβγαλε την πρώτη φωτογραφία ενός πλανήτη έξω από το ηλιακό μας σύστημα.

Παρόμοιο περιστατικό συνέβη στην κυκλοφορία του δοκιμαστικού μοντέλου Bing AI της Microsoft τον Φεβρουάριο του 2023. Το Bing ανέλυσε την οικονομική κατάσταση των κερδών της εταιρείας Gap, παρέχοντας μια εσφαλμένη περίληψη των αριθμών και γεγονότων.

Αυτά τα παραδείγματα δείχνουν ότι οι χρήστες δεν έχουν την πολυτέλεια να εμπιστεύονται τα chatbots για τη δημιουργία αληθινών απαντήσεων. Παρόλα αυτά, οι κίνδυνοι που ενέχουν οι ψευδαισθήσεις της τεχνητής νοημοσύνης (AI Hallucination) δεν περιορίζονται μονάχα στη διάδοση της παραπληροφόρησης.

Στην πραγματικότητα, σύμφωνα με την ερευνητική ομάδα του Vulcan Cyber, το ChatGPT μπορεί να δημιουργήσει διευθύνσεις URL, αναφορές και βιβλιοθήκες κώδικα που δεν υπάρχουν. Ακόμη χειρότερα μπορεί και να προτείνει κακόβουλα πακέτα λογισμικού σε ανυποψίαστους χρήστες.

Ως αποτέλεσμα, οι χρήστες που πειραματίζονται με προγράμματα LLM και γενετική AI πρέπει να κάνουν τη δέουσα ερευνά τους. Ιδιαίτερα όταν χρησιμοποιούν αυτές τις τεχνολογικές λύσεις για ζωτικής σημασίας εργασίες ο έλεγχος της ακρίβειας των αποτελέσματα είναι απαραίτητος.

Τι προκαλεί τις Ψευδαισθήσεις στην Τεχνητή Νοημοσύνη?

Μερικοί από τους βασικούς παράγοντες πίσω από τις ψευδαισθήσεις στην τεχνητή νοημοσύνη (AI Hallucination) είναι:

- Παρωχημένα/Παλιά ή χαμηλής ποιότητας δεδομένα εκπαίδευσης.

- Λανθασμένα ταξινομημένα ή επισημασμένα δεδομένα.

- Λάθη γεγονότων, ασυνέπειες ή προκαταλήψεις στα δεδομένα εκπαίδευσης.

- Ανεπαρκής προγραμματισμός για τη σωστή ερμηνεία των πληροφοριών.

- Έλλειψη συμφραζόμενων που παρέχεται από τον χρήστη.

- Δυσκολία στην κατανόηση της πρόθεσης της καθομιλουμένης, των εκφράσεων αργκό ή του σαρκασμού.

Είναι σημαντικό οι εντολές να γράφονται σε απλά αγγλικά με όσο το δυνατόν περισσότερες λεπτομέρειες. Ως εκ τούτου, είναι ευθύνη του εντολέα να εφαρμόσει επαρκή προγραμματισμό και προστατευτικά κιγκλιδώματα για να μετριάσει την πιθανότητα ψευδαισθήσεων.

Ποιοι είναι οι κίνδυνοι της ψευδαίσθησης στην Τεχνητή Νοημοσύνη?

Κύριους κίνδυνος της ψευδαίσθησης στην Τεχνητή Νοημοσύνη είναι όταν ο χρήστης βασίζεται υπερβολικά στην ακρίβεια των απαντήσεων του συστήματος AI.

Ενώ ορισμένα άτομα έχουν υποστηρίξει ότι τα συστήματα τεχνητής νοημοσύνης μπορεί να είναι «χρήσιμα όταν κάνουν λάθος». Όπως ο διευθύνων σύμβουλος της Microsoft, Satya Nadella, αναφερόμενος στο Microsoft Copilot. Ωστόσο αυτές οι τεχνολογικές λύσεις μπορούν να συμβάλλουν στη διάδοση της παραπληροφόρησης και του μίσους εάν δεν ελέγχονται.

Η παραπληροφόρηση που δημιουργείται από το LLM είναι δύσκολο να αντιμετωπιστεί. Ιδιαίτερα επειδή αυτές οι τεχνολογικές λύσεις μπορούν να δημιουργήσουν περιεχόμενο που μοιάζει λεπτομερές, πειστικό και αξιόπιστο στον χρήστη. Στην πραγματικότητα όμως οι απαντήσεις περιέχουν ψευδείς πληροφορίες, με αποτέλεσμα ο χρήστης να πιστεύει σε αναληθή γεγονότα και πληροφορίες.

Εάν υποθέσουμε ότι οι χρήστες παίρνουν τοις μετρητοίς το περιεχόμενο που δημιουργείται από τη γενετική AI χωρίς να το ελέγχουν. Τότε υπάρχει κίνδυνος να εξαπλωθούν στο Διαδίκτυο ψευδείς και αναληθείς πληροφορίες.

Τέλος, έχουμε τον κίνδυνο των νομικών ευθυνών και των ευθυνών συμμόρφωσης με προκαθορισμένους παραμέτρους. Για παράδειγμα, εάν ένας οργανισμός χρησιμοποιεί μια υπηρεσία που υποστηρίζεται από LLM για να επικοινωνήσουν με τους πελάτες τους. Η οποία όμως υπηρεσία εκδίδει οδηγίες που βλάπτουν την ιδιοκτησία του χρήστη ή αναδημιουργεί προσβλητικό περιεχόμενο. Τότε ο οργανισμός θα μπορούσε να κινδυνεύει από δικαστικές ενέργειες.

Πώς μπορείτε να ανιχνεύσετε τις AI Hallucination?

Ο καλύτερος τρόπος για έναν χρήστη να ανιχνεύσει εάν ένα σύστημα AI έχει παραισθήσεις είναι να ελέγξει χειροκίνητα το αποτέλεσμα που παρέχεται από την τεχνολογική λύση χρησιμοποιώντας ως πηγή ένα τρίτο μέρος. Ο έλεγχος γεγονότων, μεγεθών και επιχειρημάτων μέσω ειδησεογραφικών ιστότοπων, βιομηχανικών εκθέσεων, μελετών και βιβλίων με μια μηχανή αναζήτησης μπορεί να βοηθήσει ώστε να επαληθευθεί εάν μια πληροφορία είναι σωστή ή όχι.

Παρόλο που ο μη αυτόματος έλεγχος είναι μια καλή επιλογή για τους χρήστες που θέλουν να εντοπίσουν παραπληροφόρηση, σε ένα εταιρικό περιβάλλον, ενδέχεται να μην είναι υλικοτεχνικά ή οικονομικά βιώσιμο να επαληθεί κάθε τμήμα πληροφοριών χειροκίνητα.

Για το λόγο αυτό, είναι καλή ιδέα το ενδεχόμενο χρήσης αυτοματοποιημένων εργαλείων για τον έλεγχο ψευδαισθήσεων των τεχνολογικών λύσεων που βασίζονται σε γενετική AI. Για παράδειγμα, το εργαλείο ανοιχτού κώδικα NeMo Guardrails της Nvidia μπορεί να εντοπίσει ψευδαισθήσεις διασταυρώνοντας το αποτέλεσμα ενός LLM έναντι ενός άλλου.

Παρομοίως, το Got It AI προσφέρει μια λύση που ονομάζεται TruthChecker, η οποία χρησιμοποιεί AI για την ανίχνευση ψευδαισθήσεων σε περιεχόμενο που δημιουργείται από GPT-3.5+.

Φυσικά, οι οργανισμοί που χρησιμοποιούν αυτοματοποιημένα εργαλεία όπως το Nemo Guardrails και το Got It AI για να ελέγξουν τα συστήματα AI θα πρέπει να κάνουν τη δέουσα επιμέλεια για να επαληθεύσουν πόσο αποτελεσματικές είναι αυτές οι λύσεις στον εντοπισμό της παραπληροφόρησης, όπως επίσης και να εκτιμήσουν τους δυνητικούς κινδύνους για να καθορίσουν εάν υπάρχουν άλλες ενέργειες που πρέπει να ληφθούν για την εξάλειψη της πιθανής ευθύνης.

Εν Κατακλείδι

Τα AI και LLM μπορεί να ξεκλειδώσουν μερικές συναρπαστικές δυνατότητες για τις επιχειρήσεις, αλλά είναι σημαντικό για τους χρήστες να έχουν επίγνωση των κινδύνων και των περιορισμών αυτών των τεχνολογιών για να έχουν τα καλύτερα αποτελέσματα.

Τέλος, οι λύσεις AI έχουν μεγαλύτερη αξία όταν χρησιμοποιούνται για να ενισχύσουν την ανθρώπινη νοημοσύνη αντί να προσπαθούν να την αντικαταστήσουν.

Όσο οι χρήστες και οι επιχειρήσεις αναγνωρίζουν ότι τα LLM έχουν τη δυνατότητα να κατασκευάσουν πληροφορίες και επαληθεύουν τα αποτελέσματα και αλλού, ελαχιστοποιούνται οι κίνδυνοι διάδοσης ή απορρόφησης της παραπληροφόρησης.