Che cos’è un’allucinazione dell’intelligenza artificiale?

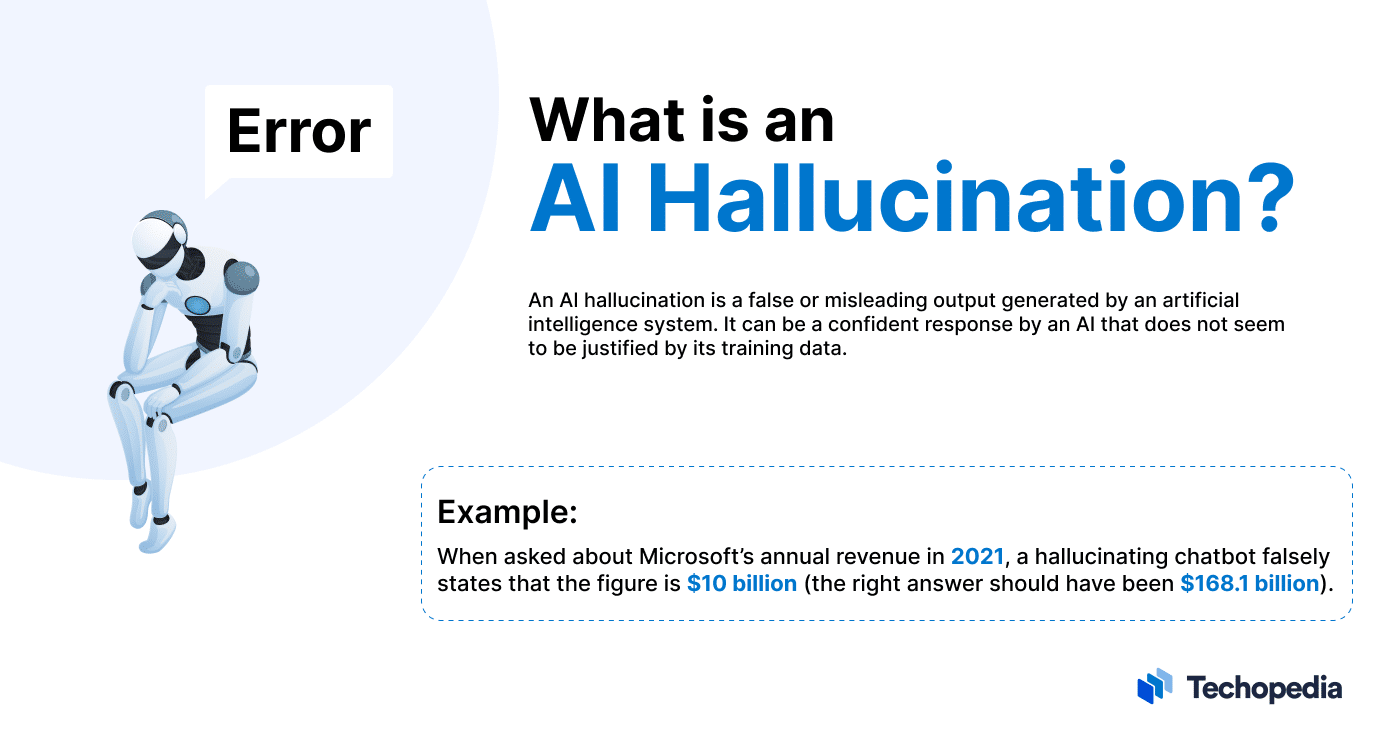

Un’allucinazione dell’intelligenza artificiale (IA) si verifica quando un modello linguistico di grandi dimensioni (LLM), come GPT4 di OpenAI o PaLM di Google, inventa informazioni o fatti falsi che non si basano su dati o eventi reali.

Avivah Litan, VP Analyst di Gartner, spiega:

Le allucinazioni sono risultati completamente inventati da modelli linguistici di grandi dimensioni. Anche se rappresentano fatti completamente inventati, l’output dell’LLM li presenta con sicurezza e autorità.

I chatbot guidati dall’intelligenza artificiale generativa possono creare qualsiasi informazione falsa, da nomi, date ed eventi storici a citazioni o persino codici.

Le allucinazioni sono così comuni che OpenAI ha pubblicato un annuncio per gli utenti di ChatGPT in cui si afferma: “ChatGPT può produrre informazioni imprecise su persone, luoghi o fatti“.

Ciononostante, la vera sfida per gli utenti è quella di riuscire a capire quali informazioni sono vere e quali no.

Esempi di allucinazioni dell’intelligenza artificiale

Sebbene vi siano molti esempi di allucinazioni dell’intelligenza artificiale che compaiono continuamente, uno dei casi più rilevanti si è verificato nell’ambito di un video promozionale pubblicato da Google nel febbraio 2023.

In quell’occasione, il suo chatbot AI Bard ha erroneamente affermato che il James Webb Space Telescope aveva scattato la prima immagine di un pianeta al di fuori del sistema solare.

Allo stesso modo, nella demo di lancio di Bing AI di Microsoft nel febbraio 2023, il chatbot ha analizzato una dichiarazione dei guadagni di Gap, fornendo un riassunto errato di fatti e cifre.

Questi esempi dimostrano che gli utenti non possono dare per scontato che i chatbot generino sempre risposte veritiere.

Tuttavia, i rischi legati alle allucinazioni dell’intelligenza artificiale vanno ben oltre la diffusione di informazioni errate.

Infatti, secondo il team di ricerca di Vulcan Cyber, ChatGPT può generare URL, riferimenti e librerie di codice inesistenti o addirittura consigliare pacchetti software potenzialmente dannosi a utenti ignari.

Di conseguenza, le organizzazioni e gli utenti che sperimentano gli LLM e l’IA generativa devono adottare la dovuta due diligence quando utilizzano queste soluzioni e controllare attentamente l’accuratezza dei risultati.

Quali sono le cause delle allucinazioni dell’IA?

Alcuni dei fattori chiave alla base delle allucinazioni dell’intelligenza artificiale sono:

- Dati di addestramento obsoleti o di bassa qualità;

- Dati classificati o etichettati in modo errato;

- Errori di fatto, incongruenze o pregiudizi nei dati di addestramento;

- Programmazione insufficiente per interpretare correttamente le informazioni;

- Mancanza di dettagli forniti dall’utente;

- Difficoltà a dedurre l’intento di espressioni colloquiali, gergali o sarcastiche.

Per ridurre al minimo il rischio di allucinazioni dell’IA è importante scrivere i prompt in modo semplice e con il maggior numero di dettagli possibile.

In ultima analisi, è responsabilità del fornitore implementare una programmazione e dei guardrail sufficienti a mitigare le potenziali allucinazioni.

Quali sono i pericoli dell’allucinazione dell’IA?

Uno dei principali pericoli dell’allucinazione dell’intelligenza artificiale è che l’utente si affidi troppo all’accuratezza dei risultati del sistema.

Sebbene alcuni personaggi illustri, come l’amministratore delegato di Microsoft Satya Nadella, abbiano sostenuto che i sistemi di IA come Microsoft Copilot possono essere “utilmente sbagliati“, queste soluzioni possono diffondere disinformazione e contenuti offensivi se vengono lasciate senza controllo.

La disinformazione generata dall’IA è difficile da contrastare perché queste soluzioni possono generare contenuti che sembrano dettagliati, convincenti e affidabili ma che, in realtà, non sono corretti, facendo sì che l’utente creda a fatti e informazioni non veritieri.

Se gli utenti prendono per buoni i contenuti generati dall’intelligenza artificiale, è possibile che informazioni false e non veritiere si diffondano su Internet.

Infine, c’è anche il rischio di incorrere in responsabilità legali e di conformità. Ad esempio, se un’organizzazione utilizza un servizio alimentato dall’IA per comunicare con i clienti e fornisce indicazioni che danneggiano la proprietà di un utente o rigurgitano contenuti offensivi, potrebbe essere passibile di azioni legali.

Come riconoscere le allucinazioni dell’IA?

Il modo migliore per rilevare se un sistema di intelligenza artificiale ha le allucinazioni è controllare manualmente i dati forniti dalla soluzione, consultando una fonte affidabile.

La verifica di fatti, dati e argomenti su siti di notizie, rapporti di settore, studi e libri tramite un motore di ricerca può aiutare a capire se un’informazione è corretta o meno.

Sebbene la verifica manuale sia una valida opzione per gli utenti che vogliono individuare le informazioni errate, in un ambiente aziendale potrebbe non essere logisticamente o economicamente conveniente verificare ogni segmento di informazione.

Per questo motivo, è una buona idea considerare l’utilizzo di strumenti automatizzati per verificare la presenza di allucinazioni nelle soluzioni di IA generativa. Ad esempio, lo strumento open-source NeMo Guardrails di Nvidia è in grado di identificare le allucinazioni effettuando un controllo incrociato tra i risultati di un LLM e un altro.

Analogamente, Got It AI offre una soluzione chiamata TruthChecker, che utilizza l’intelligenza artificiale per rilevare le allucinazioni nei contenuti generati da GPT-3.5+.

Naturalmente, le organizzazioni che utilizzano strumenti automatizzati come Nemo Guardrails e Got It AI per il fact-checking dei sistemi di intelligenza artificiale devono verificare l’efficacia di queste soluzioni nell’identificare la disinformazione e condurre una valutazione del rischio per determinare se vi siano altre azioni da intraprendere per eliminare potenziali responsabilità.

In conclusione

L’IA e gli LLM possono offrire alle aziende funzionalità interessanti, ma è importante che gli utenti siano consapevoli dei rischi e dei limiti di queste tecnologie per ottenere i migliori risultati.

In definitiva, le soluzioni di IA forniscono il massimo valore quando vengono utilizzate per aumentare l’intelligenza umana, piuttosto che tentare di sostituirla.